Der Google AI Mode kommt und die KI- Inhalte (AI Overviews) sind schon da.

Wir erklären Anhand der Verarbeitung von Suchanfragen, worauf es heute im SEO, GEO oder AIO wirklich ankommt.

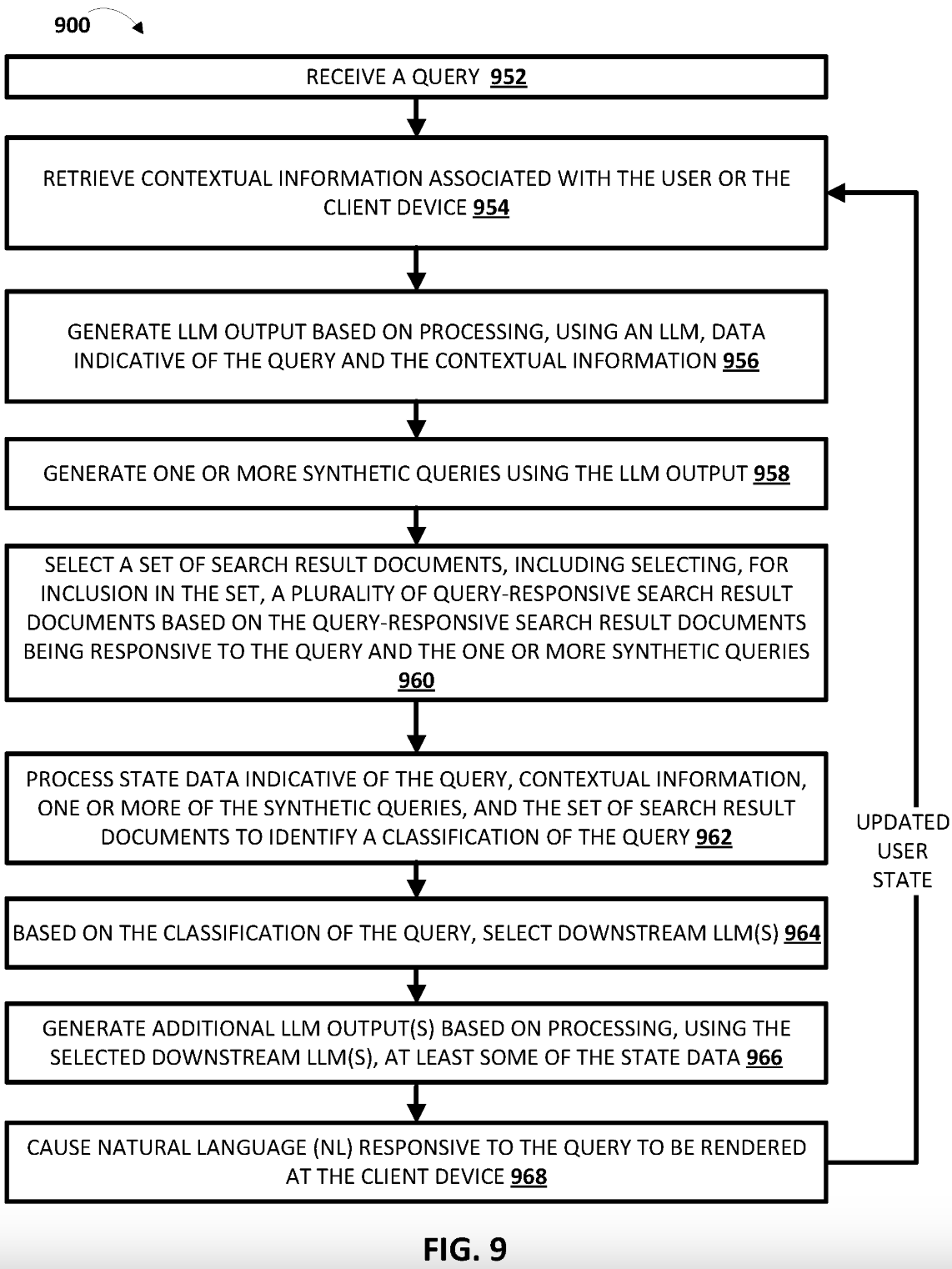

Am 29.August 2024 veröffentlichte Google das Patent zur Verarbeitung von Suchanfragen durch Google AI. Aus den Einzelschritten lassen sich Einzelkriterien für die Zukunft des SEO (GEO, AIO) ableiten.

Wir wollen mit diesem Artikel "Licht ins Dunkel bringen" und erklären auf einfache Art und Weise jeden Einzelschritt des Google AI Mode.

Kurz und knapp oder tl;dr...

Was Du in diesem Artikel zum AI Mode erfährst:

- wie der AI Mode in Einzelschritten arbeitet

- was ist das "Query Fan-Out"

- welche Bedeutung die Einzelschritte des AI Modes haben

- wie der AI Mode in den USA derzeit aussieht

- welche Auswirkungen das auf SEO, GEO und AIO hat

- was der Attributed Influence Value (AIV) bedeutet

- weitere Videos zum Thema beim Podcast 2:n

Auszug aus dem Google Patent

Wenn Du keine Lust oder Zeit zum Lesen hast, hier eine schnelle Übersicht, wie der AI Mode mit Gemini 2.5 in Einzelschritten arbeitet:

Schritt 1: Empfang und Interpretation der Suchanfrage

Zu Beginn des Prozesses steht die Eingabe einer Suchanfrage durch den Nutzer. Diese Eingabe kann multimodal und somit auf verschiedenste Arten erfolgen, wie z.B. Text, per Spracheingabe, durch das Hochladen eines Bildes oder auch durch Bildübertragung einer Kamera in Echtzeit. Sobald die Anfrage empfangen wurde, startet automatisch ein komplexer und umfassender Prozess zur Informationsgewinnung, der weit über die reine wörtliche Übereinstimmung von Suchbegriffen hinausgeht und im folgendem beschreiben wird.

Schritt 2: Kontextuelle Informationen werden abgerufen

Das System zieht Informationen zum Nutzer und Gerät heran. Dazu gehören frühere Anfragen in derselben Sitzung, der Standort, mit dem Konto verknüpfte Verhaltensweisen wie zum Beispiel aus Gmail oder Maps sowie Gerätesignale und ein persistenter Speicher, der den Nutzerzustand repräsentiert. Diese Informationen helfen dem System, die aktuelle Anfrage im richtigen zeitlichen und verhaltensbezogenen Kontext zu verstehen.

Schritt 3: Erste Verarbeitung durch ein Large Language Model (LLM)

Im nächsten Schritt verarbeitet ein Large Language Model (LLM), im Falle des AI-Modes derzeit Gemini 2.5, die Suchanfrage gemeinsam mit sämtlichen bis dahin gesammelten Kontextinformationen. Das Modell leitet daraus erste, grundlegende Schlussfolgerungen ab. Dazu gehören insbesondere die Identifizierung der Nutzerintention, die Klärung möglicher Mehrdeutigkeiten in der Anfrage sowie erste Kategorisierungen und Klassifizierungen der Anfrageart. Dieser Schritt ist zentral, da er die interne Grundlage dafür schafft, was genau das System als Ziel oder Absicht des Nutzers interpretiert.

Schritt 4: Automatisierte Generierung zusätzlicher Suchanfragen (Query Fan-Out)

Basierend auf den ersten Schlussfolgerungen des LLM generiert das System automatisch mehrere ergänzende Suchanfragen. Dieser Vorgang, der als Query Fan-Out bezeichnet wird, dient dazu, die ursprüngliche Anfrage umfassender und differenzierter zu beantworten. Dabei werden verwandte Begriffe, implizite Bedeutungen, alternative Formulierungen sowie vergleichende Begriffe berücksichtigt. Dies geschieht im sogenannten Query Fan-Out, einem Verfahren, bei dem die ursprüngliche Anfrage durch verwandte Begriffe und semantische Zusammenhänge angereichert wird. Ziel ist es, die wahre Intention hinter der Anfrage möglichst genau zu erfassen. Query Fan-Out ist ein technischer Begriff, der vor allem im Zusammenhang mit Suchmaschinen-Infrastruktur wie bei Google verwendet wird. Es beschreibt, wie eine einzelne Suchanfrage ("Query") an viele verschiedene Backend-Systeme oder Server verteilt wird, um möglichst schnell und umfassend relevante Ergebnisse zu liefern.

Was passiert beim Query Fan-Out bei Google?

- Weiterleitung ("Fan-Out") der Anfrage: Die Suchanfrage wird vom Google-Frontend an zahlreiche Backend-Server gleichzeitig weitergeleitet. Diese Server halten Teile des Suchindexes oder spezialisierte Datenbanken bereit. Google hat den Suchindex weltweit auf viele Server verteilt, die jeweils einen "Shard" (Teilmenge des Indexes) verwalten.

- Parallelisierung: Durch das Fan-Out werden Dutzende bis Hunderte von Servern parallel abgefragt, um eine maximale Abdeckung des Indexes und eine niedrige Latenz zu erreichen.

- Aggregation der Ergebnisse: Jeder angesprochene Server gibt die relevantesten Treffer zurück, die zusammengeführt und verarbeitet werden.

Auch Kontextinformationen aus vorherigen Suchverläufen des Nutzers und Nutzerverhalten fließen mit ein. Das Ergebnis sind parallele Suchanfragen, die tiefergehende und umfassendere Informationen liefern. Das System verarbeitet „einen Satz von Suchergebnisdokumenten“, wobei „die Auswahl des Satzes von Suchergebnisdokumenten die Auswahl mehrerer abfrageresponsiver Suchergebnisdokumente umfasst, die in den Satz aufgenommen werden sollen, basierend darauf, dass die abfrageresponsiven Suchergebnisdokumente auf die Abfrage und die eine oder mehrere synthetische Abfragen reagieren.“ - so die Ersteinschätzung von Michael King, Gründer von iPullRank.

Schritt 5: Abruf relevanter Dokumente aus dem Index

Im Anschluss an die Generierung der erweiterten Suchanfragen durchsucht das System den Index nach passenden Dokumenten. Dabei berücksichtigt es nicht nur die ursprüngliche Nutzeranfrage, sondern auch sämtliche automatisch erzeugten Anfragen aus dem vorherigen Schritt. Ziel ist es, Dokumente zu finden, die unterschiedliche Aspekte der vermuteten Nutzerintention abdecken. Die Auswahl dieser Dokumente erfolgt anhand zahlreicher Kriterien – darunter auch nutzerspezifische Faktoren wie Suchhistorie, Standort oder aktuelle Interessenlage. Statt rein auf Keyword-Übereinstimmungen zu setzen, basiert dieser Vorgang auf "Document Retrieval" – einem Verfahren, das semantische Ähnlichkeiten zwischen Anfragen und Dokumenten analysiert. Inhalte stehen somit in direkter Konkurrenz auf Basis ihres Bedeutungsgehalts, nicht bloß ihrer Wortwahl.

Schritt 6: Klassifizierung der Anfrage anhand des Gesamtkontexts

Nach dem Dokumentenabruf ordnet das System die Anfrage einer bestimmten Kategorie zu. Hierbei wird die ursprüngliche Suchanfrage, alle Kontextdaten, die generierten Suchanfragen sowie die gefundenen Dokumente berücksichtigt. Ziel ist es zu bestimmen, welche Art von Antwortformat am besten geeignet ist – etwa eine informative Übersicht, ein Produktvergleich oder ein konkretes Handlungsangebot. Zudem wird geprüft, ob die Anfrage vollständig verstanden wurde oder noch weitere Klärung nötig ist. Dieser Vorgang wird als „Query Classification“ bezeichnet und ergibt den „Instructional Content“.

Schritt 7: Auswahl spezialisierter LLMs zur Antwortgenerierung

Auf Basis der Klassifizierung greift das System nun auf spezialisierte Large Language Models zurück, die auf spezifische Aufgaben trainiert wurden. Dazu gehören etwa Modelle zur Informationsverdichtung, Datenextraktion, Übersetzung oder Entscheidungsunterstützung. Je nach Art der Anfrage können mehrere dieser spezialisierten Modelle gleichzeitig zum Einsatz kommen. Hierbei sieht das jeweilige LLM, dass letztendlich mit Ihren Inhalten interagiert, möglicherweise nie das gesamte Dokument, sondern verarbeitet nur eine Passage oder ein strukturiertes Element wie eine Liste, eine Tabelle oder ein semantisches Tripel. Die LLMs übernehmen die Aufgabe, die gesammelten Informationen aus den Dokumenten in eine strukturierte, kohärente und nutzerfreundliche Antwort zu überführen.

Schritt 8: Generierung der finalen Ausgabe

Die spezialisierten LLMs liefern schließlich eine zusammengefasste, oft multimodal angereicherte Antwort in natürlicher Sprache. Diese kann Elemente aus Text, Bildern, Videos oder Audio enthalten und stellt das Endprodukt des gesamten Suchprozesses dar. Sie ist auf Relevanz, Verständlichkeit und Nützlichkeit für den Nutzer hin optimiert.

Schritt 9: Darstellung der Antwort auf dem Endgerät (auch multimodal)

Die generierte Antwort wird abschließend an das Gerät des Nutzers übermittelt und dort angezeigt. Dabei können interaktive Elemente wie Quellenverweise, Zitate oder weiterführende Links eingebunden sein. Wenn eine Website als Quelle genannt wird, kann dies eventuell zu einem tatsächlichen Besuch dieser Seite führen - muss aber nicht.

Hier kannst Du Dir einen Vorschau des AI Modes ansehen:

Unser Fazit und die Bedeutung für SEO, GEO, AIO.

Die gleiche Anfrage kann für verschiedene Nutzer zu völlig unterschiedlichen Suchergebnis- Darstellungen führen. Das erschwert das Tracking von Rankings und betont die Bedeutung einer konsistenten Präsenz über verschiedene Online-Bereiche hinweg. Eine Optimierung für ein Ranking in den AI-Overviews oder dem Google AI Mode ist somit übergreifend nicht möglich, da alle präsentierten Inhalte personalisiert sind. Die Sichtbarkeit von Inhalten hängt von ihrer Relevanz für alle Ebenen des Query-Fan-Out-Prozesses ab. Inhalte, die ausschließlich für die ursprüngliche Suchanfrage optimiert sind, könnten unrelevant werden, wenn sie nicht auch auf die vom System generierten, sekundären Suchanfragen abgestimmt sind. Somit gelten weiterhin alle bekannten SEO- Grundlagen (technisch & inhaltlich) und im Rahmen von Generative Engine Optimization (GEO) oder AI- Optimization (AIO) gilt es, mehr Relevanz zu allen Themen des Unternehmens im Internet aufzubauen. Backlinks, Studien und Statistiken stärken die Möglichkeiten zur KI- Wahrnehmbarkeit.

Verwandte Konzepte und unterstützende Themen müssen optimiert werden, anstatt sich auf einzelne Schlüsselwörter zu konzentrieren. Erfolgreiches SEO bedeutet daher, Inhalte so zu gestalten, dass sie nicht nur explizite, sondern auch potenziell verwandte, implizite und kontextuelle Suchanfragen abdecken.

Eine Erwähnung in einer KI-generierten Antwort garantiert keinen Traffic. Entscheidend ist, wie stark die eigene Seite zur Antwort beiträgt – z.B. gemessen am sogenannten "Attributed Influence Value (AIV)".

Was ist der Attributed Influence Value (AIV)?

Der Begriff Attributed Influence Value (AIV) ist kein offiziell definierter Standard, sondern ein analytisches Konzept. Attributed Influence Value beschreibt den geschätzten Einfluss einer bestimmten Quelle oder Website auf die generierte KI-Antwort, selbst wenn kein direkter Klick oder Traffic entsteht. Es ist ein Versuch, Sichtbarkeit und indirekte Wirkung zu messen, wenn eine Website in KI-Antworten erscheint – beispielsweise als zitierte Quelle, eingebetteter Link oder als inhaltliche Grundlage.

Wichtige Aspekte:

- Zuschreibung statt Klicks: AIV geht über klassische Metriken wie CTR oder Verweildauer hinaus und versucht, den inhaltlichen Beitrag einer Quelle zu quantifizieren – also wie stark eine Website den Inhalt der Antwort beeinflusst hat, auch wenn sie nicht direkt angeklickt wurde.

- Inhaltsgewichtung: Wenn ein bestimmter Absatz, eine Tabelle oder eine Liste in eine KI-Antwort einfließt, kann dieser Abschnitt einen höheren AIV besitzen als ein vollständiger, aber nicht zitierter Artikel.

- Vertrauensaufbau und Markenwirkung: Auch ohne Traffic kann AIV helfen, die Marke zu stärken. Eine häufig zitierte Seite gewinnt an Reputation, selbst wenn Nutzer auf der Plattform (z. B. bei Google) bleiben.

- Nutzerverhalten wird komplexer: Nutzer holen sich direkt aus der Antwortbox Informationen, klicken ggf. nicht mehr – aber behalten die Quelle im Kopf oder kehren später zurück.

- Warum AIV? Da KI-Systeme Antworten aus mehreren Quellen synthetisieren, ist es schwieriger zu messen, wie viel Einfluss ein einzelner Beitrag hatte. Klassische KPIs verlieren an Aussagekraft. AIV versucht, diese Lücke zu schließen und ist ein strategischer Kennwert. Der AIV ist kein fester Metrik-Standard, aber ein sehr relevantes Konzept für die Zukunft der Search Visibility im KI-Zeitalter.

Zusammenfassend gelten SEO- Grundlagen nach wie vor und werden noch umfangreicher. Um wirkliche Ergebnisse in den AI Overviews und dem AI Mode bei Google zu erzielen, müssen Markenbekanntheit (Authority) und Expertenstatus mit einzigartigen Inhalten nachhaltig gestärkt werden.

mehr Informationen zu GEO Videopodcast 2:n zu GEO Videopodcast 2:n zu AI Overviews